Sztuczna inteligencja może wprowadzać w błąd radiologów, którzy zbytnio polegają na jej podpowiedziach. Między nowymi technologiami SI a możliwością ich praktycznego zastosowania w medycynie jest jeszcze duży rozdźwięk – przekonują naukowcy.

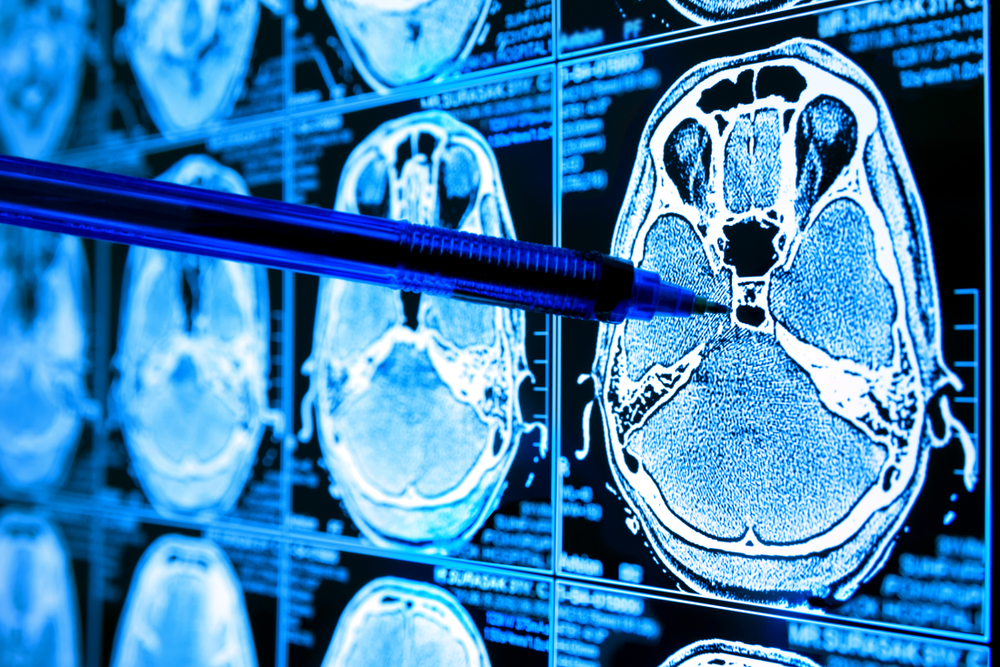

Podczas podejmowania diagnostycznych decyzji radiolodzy i inni lekarze mogą zbytnio polegać na sztucznej inteligencji. To wynik badania opublikowanego w czasopiśmie „Radiology”.

„Do 2022 roku amerykańska Agencja Żywności i Leków (FDA) zatwierdziła 190 programów SI do zastosowań w radiologii” – mówi jeden głównych autorów publikacji, dr Paul H. Yi z St. Jude Children’s Research Hospital in Memphis, Tennessee.

Kluczowe jest zbudowanie zaufania

„Jednak pojawiła się luka między dowodami koncepcyjnymi odnośnie SI a jej zastosowaniem w rzeczywistej praktyce klinicznej. Aby zlikwidować tę lukę, kluczowe jest zbudowanie odpowiedniego zaufania do wskazań sztucznej inteligencji” – wyjaśnia.

W przeprowadzonym w wielu ośrodkach badaniu wzięło udział 220 specjalistów - radiologów, lekarzy medycyny wewnętrznej i medycyny ratunkowej, którzy oceniali zdjęcia rentgenowskie klatki piersiowej z uwzględnieniem wskazówek udzielanych przez system SI.

Każdy z lekarzy miał za zadanie przeanalizować osiem przypadków badania rentgenowskiego, wraz z sugestiami pochodzącymi od symulowanego asystenta SI, którego skuteczność diagnostyczna była porównywalna z ekspertami w tej dziedzinie. Wybrany zestaw przypadków odzwierciedlał rzeczywistą praktykę kliniczną. W każdym przypadku specjalistom, oprócz obrazów i wskazówek SI przedstawiano historię kliniczną pacjenta.

Sztuczna inteligencja dostarczała poprawną lub błędną diagnozę wraz z tzw. lokalnymi lub globalnymi wyjaśnieniami. W lokalnych wyjaśnieniach wyróżniała fragmenty obrazu uznane za najważniejsze. W przypadku wyjaśnień globalnych przedstawiała podobne obrazy z wcześniejszych przypadków, aby pokazać, jak doszła do swojej diagnozy.

Lekarze mogli zaakceptować, zmodyfikować lub odrzucić sugestie SI. Poproszono ich również o określenie poziomu pewności co do swoich ustaleń oraz o ocenę przydatności uzyskanych wskazówek.

Eksperci bardziej polegali na sugestiach AI

Wyniki wykazały, że eksperci częściej dostosowywali swoje decyzje diagnostyczne do sugestii SI i poświęcali mniej czasu na ich analizę, gdy system dostarczał lokalnych wyjaśnień.

Przy tym, gdy sugestie SI były poprawne, średnia dokładność diagnostyczna specjalistów wynosiła 92,8 proc., przy lokalnych wyjaśnieniach i 85,3 proc. przy wyjaśnieniach globalnych.

Natomiast, gdy sugestie były błędne, dokładność lekarzy wynosiła już tylko, odpowiednio 23,6 i 26,1 proc.

„Kiedy zbytnio polegamy na tym, co mówi nam komputer, staje się to problemem, ponieważ SI nie zawsze ma rację. Uważam, że jako radiolodzy korzystający z tych systemów, musimy być świadomi tego typu pułapek i pamiętać o naszych procedurach diagnostycznych oraz szkoleniu” – podkreśla dr Yi.

„Jestem zdania, że kluczem jest współpraca między przemysłem i badaczami zajmującymi się opieką zdrowotną. Mam nadzieję, że nasz artykuł rozpocznie dialog i owocną współpracę” – dodaje.(PAP)

Marek Matacz